Technische SEO is nog steeds een superbelangrijk onderdeel voor de gezondheid van je website. Wij zijn er ook dan ook structureel mee bezig om nieuwe, interessante methoden te vinden om SEO te verbeteren. Daarom gaan wij het hebben over de functie Crawlstatistieken van Google Search Console.

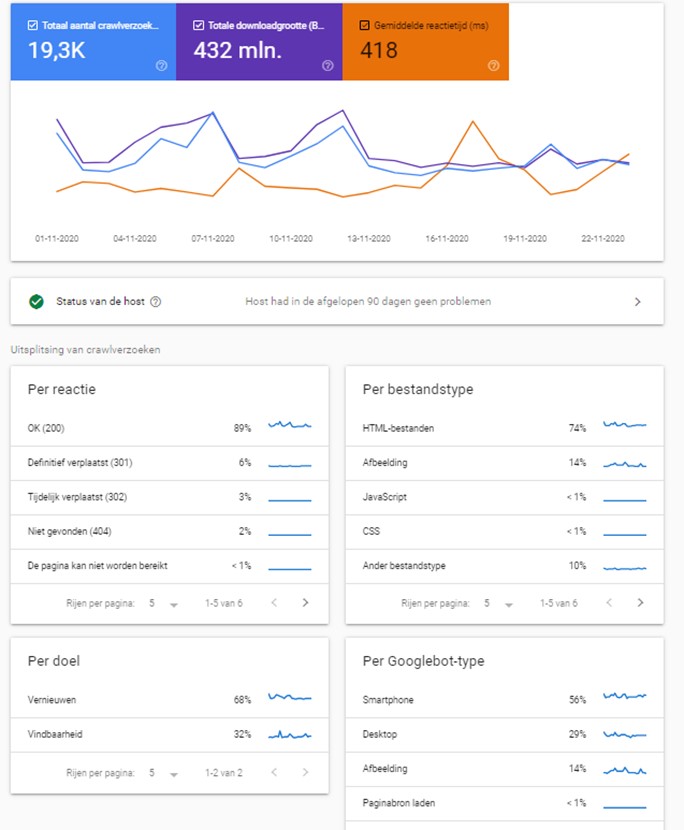

Google heeft onlangs een gloednieuwe versie van het rapport Crawlstatistieken in Search Console gelanceerd. Wij zijn er als eerste bij om jou uit te leggen wat je hier allemaal mee kunt en hoe je jouw website technisch kunt verbeteren. Met deze tool wordt het nog duidelijker hoe Google de website crawlt. De nieuwe versie ziet er zo uit en is te vinden onder Instellingen; crawlstatistieken:

Je ziet in één oogopslag wat de status van de host is en er is een uitsplitsing gemaakt van crawlverzoeken. Zo kun je niet alleen snel zien wat de verschillende status codes op je website zijn, maar deze ook uitsplitsen per type (smartphone, desktop etc).

Wat zijn de nieuwe functies?

Het nieuwe rapport Crawlstatistieken biedt de volgende nieuwe functies aan:

- Totaal aantal verzoeken gegroepeerd op:

- Responscodes; 200, 404, 301 etc.

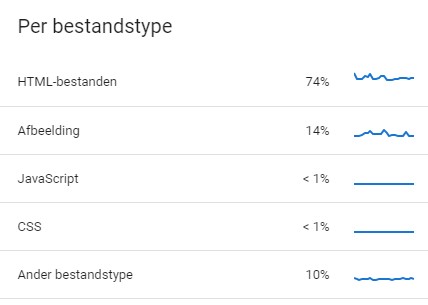

- Gecrawlde bestandstypes; HTML, JSON, Javascript etc.

- Crawldoel; Vernieuwen en vindbaarheid

- Googlebot-type; Smartphone, Desktop, Afbeelding etc.

- Gedetailleerde informatie over de hoststatus

- URL-voorbeelden om te laten zien waar verzoeken op je site plaatsvonden

- Een uitgebreide samenvatting voor eigendommen met meerdere hosts en ondersteuning voor domeineigenschappen

Wat kun je nu met dit crawlstatistieken report?

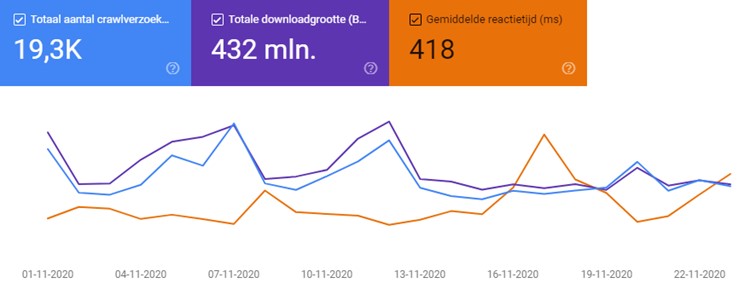

Met de Crawlstatistieken kun je de totalen van Google-crawlgegevens en overurengrafieken bekijken voor: totale verzoeken, totale downloadgrootte en gemiddelde reactietijd.

Hier een voorbeeld:

Bij het totaal aantal crawlverzoeken kun je zien hoeveel crawlverzoeken zijn ingediend voor URL’s op je site, ongeacht of een verzoek geslaagd is of niet. De totale downloadgrootte geeft het totaal aantal bytes weer, die via je site zijn gedownload tijdens het crawlproces. De gemiddelde reactietijd geeft de tijd weer die Google nodig heeft, voor het ophalen van alle bronnen.

Een hoge crawlsnelheid is bijna altijd wenselijk. Dat betekent dat de bots je site gemakkelijker en sneller kunnen indexeren. Kortom, de gegevens van Crawlstatistieken zijn ontzettend belangrijk. Als je crawlsnelheid laag is, kan dit slecht zijn voor je SEO.

Als je een plotselinge daling ziet, kan één van de volgende dingen gebeuren:

- Mogelijk heb je een defecte code (zoals HTML) of niet-ondersteunde inhoud, op één of meer van je pagina’s. Als je onlangs een nieuwe code hebt toegevoegd, kan dit het probleem zijn.

- Je robots.txt-bestand blokkeert mogelijk te veel. Het is een goede gewoonte om je robots.txt-bestand zorgvuldig aan te passen, maar je kunt ook bronnen blokkeren die Googlebot nodig heeft om je site goed te crawlen.

- Je site bevat verouderde inhoud. Iedereen weet dat Google van nieuwe content houdt. Wanneer je een wijziging aanbrengt op een pagina op je site, wordt Google op de hoogte gebracht van die wijziging en wordt je pagina opnieuw gecrawld. Elke keer dat Googlebot één van je pagina’s crawlt, wordt je pagina opnieuw geïndexeerd. Als je pagina van super hoge kwaliteit is, krijg je er waarschijnlijk een betere positie van. Maar heeft jouw website veel oude inhoud, dan wordt deze niet zo vaak gecrawld en zal de crawlsnelheid dalen. Dat wil je natuurlijk niet!

Het punt is dat het belangrijk is om je crawlsnelheid te controleren en in de gaten te houden. Het is met name goed om te zien of je relevante pagina’s veelal gecrawld worden. Dat kun je goed checken met bijvoorbeeld exports.

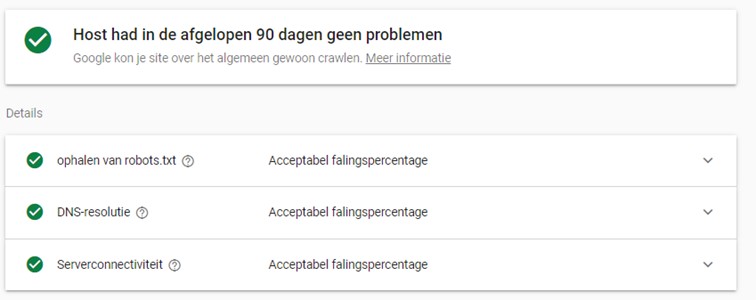

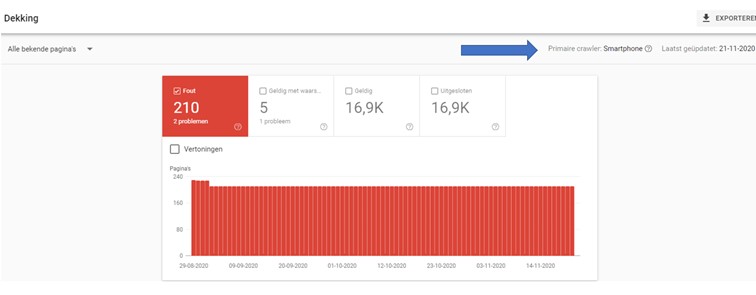

Status van de host

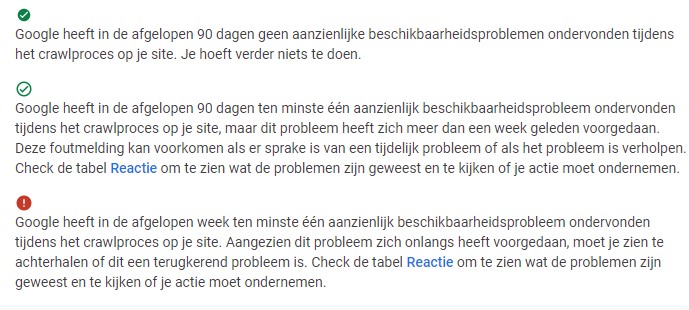

De ‘Status van de host’ geeft aan of Google beschikbaarheidsproblemen heeft ondervonden tijdens het crawlen van je site in de afgelopen 90 dagen.

De status kan één van de volgende waarden zijn:

Door te klikken op reactie, kun je erachter komen wat de reactie codes zijn.

In dit voorbeeld ziet het er goed uit. Maar een paar voorbeelden van ‘foute reactie’ kunnen zijn;

– Robots.txt niet beschikbaar is

– Niet geautoriseerde pagina’s

– Serverfouten

– De DNS die niet reageert etc.

Crawlreacties

In de tabel ‘crawlreacties’ worden de reacties weergegeven die Google heeft ontvangen tijdens het crawlen van je site, gegroepeerd op reactietype en met daarachter het percentage van alle crawlreacties.

De gegevens zijn gebaseerd op het totale aantal verzoeken, niet op basis van URL. Als Google dus 2 keer een URL heeft aangevraagd en de eerste keer ‘Serverfout (500)’ ontvangt en de tweede keer ‘OK (200)’, is de reactie 50% ‘Serverfout’ en 50% ‘OK’. Je kunt voorbeeld-URL’s van elk type bekijken door op een rij in de groeperingstabel te klikken.

Waar moet je nu op letten?

De meeste reacties moeten een 200 code geven, of een andere goede reactie zijn zoals een 301 of 302. Mogelijke goede response code kan ‘geblokkeerd door robots,txt’ zijn, let er wel op dat je geen pagina’s of bronnen blokkeert die je wel door Google wilt laten crawlen.

Slechte response codes, zoals eerder in dit artikel aangegeven, zijn bijv een robots.txt die niet beschikbaar is, 407 codes (niet geautoriseerd), serverfouten, clientfouten, time-out van een pagina etc. Als dit percentage hoog is, moet je hier actie op ondernemen.

Als je een idee wilt krijgen van het soort bron dat een crawlprobleem of lager reactiepercentage geeft, dan kun je naar deze grafiek kijken. Je kunt klikken op de verschillende types om een idee te krijgen wat de gemiddelde reactietijd is per datum en het aantal verzoeken.

Zo kun je bijv. zien of Google veel kleine afbeeldingen aanvraagt die moeten worden geblokkeerd, of dat Google bronnen aanvraagt die worden gehost op een andere minder responsive site.

Crawldoel

Het heb je de mogelijkheden vernieuwen en vindbaarheid. Vernieuwen houdt in dat Google een nieuwe crawl van een bekende pagina heeft gedaan. Bij vindbaarheid/ontdekking staan de opgevraagde URL’s die nooit eerder door Google gecrawld zijn.

Wat je hier bijvoorbeeld mee kunt doen, is als je vaak veranderende pagina’s hebt die niet vaak genoeg gecrawld worden. Dan kun je ervoor zorgen dat deze in de sitemap worden opgenomen. Heb je pagina’s die minder vaak worden geüpdatet, dan moet je specifiek vragen voor een nieuwe crawl. Heb je veel nieuwe content toegevoegd, dan zou je in deze periode dus een piek moeten zien in de vindbaarheid crawls.

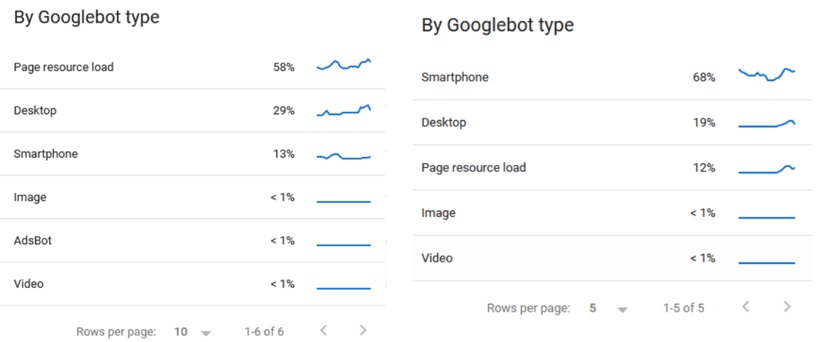

Googlebot type

Deze grafiek geeft informatie weer over de user-agent die wordt gebruikt om de crawl uit te voeren.

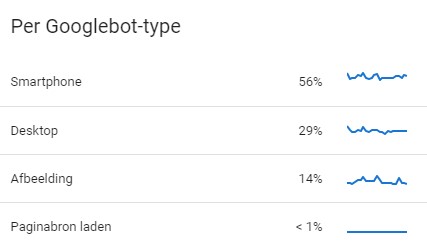

e verschillende types vertonen ook verschillend gedrag. Zo heb je voor Smartphone de Googlebot-smartphone, voor desktop de Googlebot-desktop en ook voor afbeeldingen, video, ads etc heb je verschillende agenttypes. Echter, de meeste crawls komen van de primaire crawler. Dit is het standaard type user agent die Google gebruikt om je site te crawlen. Deze kun je controleren in Dekking. Vervolgens kun je rechtboven de primaire crawler zien:

Is er sprake van crawlpieken? Dan is het goed om je user agent te checken. Zo kun je achterhalen waarom je crawlsnelheid te hoog, te laag of is toegenomen. Wordt je site te vaak gecrawld, dan kunnen er beschikbaarheidsproblemen ontstaan.

Wat doet het Crawlstatistieken rapport ten opzichte van de oude versie?

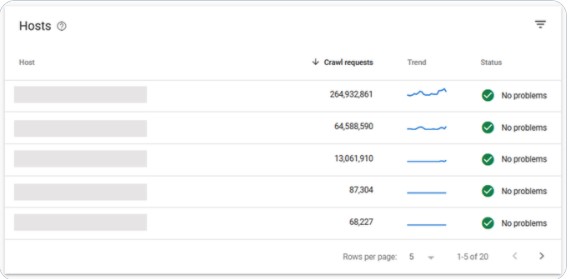

Het nieuwe rapport Crawlstatistieken helpt je nog beter te begrijpen hoe Googlebot je site crawlt. Eén van de vele leuke dingen aan het nieuwe rapport Crawlstatistieken in GSC is dat het domein brede gegevens toont (terwijl het vorige crawlstatistiekenrapport alleen werkte op het individuele propertyniveau).

Je kunt nu dus zien welke sub domeinen Google daadwerkelijk crawlt.

Wat ook interessant is aan de nieuwe versie, is dat je kunt zien waar je crawl-inspanning wordt besteed. Eén van een site die veel resources verbruikt en langzaam laadt, en één van een veel schonere en sneller ladende site.

We willen dat Google de meeste crawl-inspanningen besteedt aan het vinden van nieuwe en bijgewerkte inhoud en het crawlen van relevante pagina’s. Het kan zijn dat op die pagina’s ook afbeeldingen zijn ingeladen, dus die wil je dan ook mee laten crawlen.

Door de crawlgeschiedenis van Google in de overurengrafieken te bekijken, de bestandstypen en bestandsgrootten die door je site worden geretourneerd en de details van crawlverzoeken in de voorbeeldlijsten te bekijken, kun je heel veel crawlproblemen snel oplossen.

Meer te weten komen over de crawlstatistieken binnen Google Search Console?

Het is misschien niet voor iedereen vanzelfsprekend wat het allemaal inhoud, maar dat maakt het er niet minder belangrijk op. Heb je vragen over zoekmachine optimalisatie, over de crawlstatistieken binnen Google Search Console of überhaupt over online marketing. Laat het ons weten! Wij helpen jou graag om jouw organische vindbaarheid te vergroten. Neem dan eens contact met ons op en hopelijk zien we jou dan snel!